DeepSeek R1推理模型完全本地部署保姆级教程,断网运行,无惧隐私威胁,大语言模型推理时调参,CPU GPU混合推理,32B轻松本地部署

摘要:本教程详细介绍了DeepSeek R1推理模型的本地部署过程,包括断网运行和隐私保护的特点。该模型支持CPU和GPU混合推理,并提供了保姆级的操作指南,即使在不联网的情况下也能轻松部署。该模型还提供了大语言模型的推理调参功能,可在本地实现高效的推理计算。整个教程简洁明了,适合初学者快速上手。

目录导读:

在当今时代,人工智能的快速发展推动了各种应用场景的智能化升级,DeepSeek R1推理模型作为大语言模型的一种,广泛应用于自然语言处理领域,本文将为大家提供DeepSeek R1推理模型的完全本地部署保姆级教程,帮助读者轻松掌握该模型的本地部署及应用,本教程适用于断网环境,无需担心隐私泄露问题,我们将介绍如何在推理过程中进行参数调整,实现CPU和GPU混合推理,以及如何在32B环境下进行本地部署。

准备工作

在开始部署DeepSeek R1推理模型之前,我们需要做好以下准备工作:

1、确认计算机配置:确保计算机具备足够的硬件资源,如CPU、GPU和内存。

2、安装必要的软件:安装Python编程环境、相关依赖库以及深度学习框架(如TensorFlow或PyTorch)。

3、获取DeepSeek R1推理模型:从官方网站或开源平台下载DeepSeek R1推理模型及相关文件。

完全本地部署

按照以下步骤完成DeepSeek R1推理模型的完全本地部署:

1、解压模型文件:将下载的DeepSeek R1模型文件解压至本地目录。

2、配置环境变量:设置Python环境变量,确保相关依赖库能够正确加载。

3、编写运行脚本:根据模型需求,编写相应的运行脚本,以便启动推理程序。

4、测试模型:运行测试脚本,验证模型的准确性和性能。

断网运行

为确保隐私安全,我们可以在断网环境下运行DeepSeek R1推理模型,具体步骤如下:

1、断开网络连接:在计算机上断开网络连接。

2、运行模型:在断网状态下,运行DeepSeek R1推理模型的运行脚本。

3、监控模型运行:确保模型在断网状态下正常运行,并监控其性能表现。

无惧隐私威胁

在本地部署DeepSeek R1推理模型时,无需将数据传输至云端或远程服务器,从而避免了隐私泄露的风险,我们在断网状态下运行模型,进一步保障了数据隐私安全。

大语言模型推理时调参

在DeepSeek R1推理模型中,我们可以根据实际需求进行参数调整,以优化模型性能,常见的调参方法包括:

1、调整批次大小:根据硬件资源情况,适当调整批次大小,以平衡计算性能和内存消耗。

2、优化网络结构:根据实际需求,对模型网络结构进行优化,如增减层数、调整神经元数量等。

3、调整学习率:尝试不同的学习率,以找到最佳的学习速率,从而提高模型训练效果。

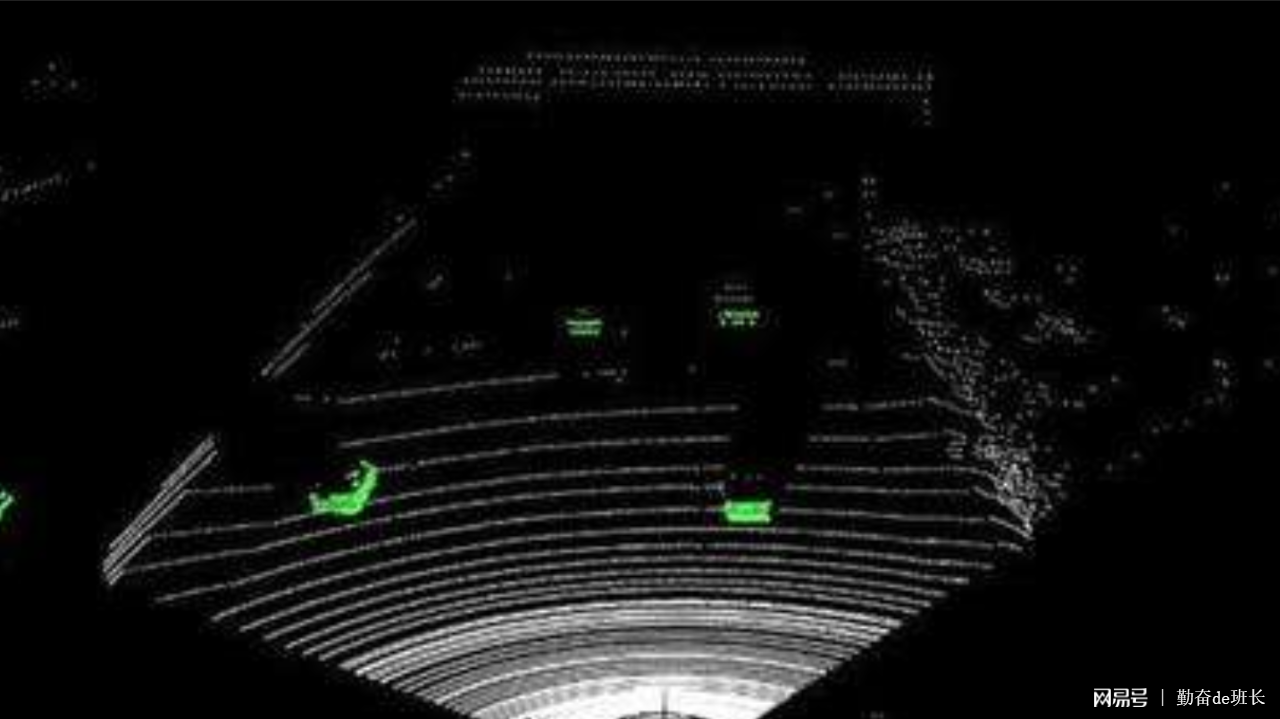

CPU GPU混合推理

DeepSeek R1推理模型支持CPU和GPU混合推理,以提高计算性能,在使用混合推理时,需要注意以下几点:

1、确认硬件支持:确保计算机配备了CPU和GPU,并安装了相应的驱动程序。

2、配置计算资源:在模型部署时,合理配置CPU和GPU的计算资源,以充分利用硬件性能。

3、编写混合推理代码:根据模型需求,编写支持CPU和GPU混合推理的代码。

32B轻松本地部署

DeepSeek R1推理模型可在32B环境下轻松本地部署,在部署过程中,需要注意以下几点:

1、选择合适的Python版本:确保使用的Python版本与模型需求相匹配。

2、安装依赖库:在32B环境下安装必要的依赖库,以确保模型正常运行。

3、监控资源消耗:在32B环境下运行模型时,关注资源消耗情况,以确保系统稳定运行。

常见问题及解决方案

在部署和运行过程中,可能会遇到一些常见问题,以下是一些常见问题及解决方案:

1、模型加载失败:检查模型文件路径是否正确,确保模型文件完整无损。

2、运行速度慢:尝试优化模型参数,合理利用硬件资源,提高计算性能。

3、隐私泄露风险:确保在断网状态下运行模型,避免数据传输过程中的隐私泄露风险。

本文为大家提供了DeepSeek R1推理模型的完全本地部署保姆级教程,包括准备工作、完全本地部署、断网运行、无惧隐私威胁、大语言模型推理时调参、CPU GPU混合推理以及32B轻松本地部署等方面,通过本文的学习,读者可以轻松掌握DeepSeek R1推理模型的本地部署及应用,为自然语言处理任务提供有力支持。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号