摘要:OpenAI采用自我博弈强化学习(RL)技术路线进行智能体训练,通过模拟复杂环境下的决策过程,提升智能体的自适应能力和决策水平。该技术路线的推演包括构建仿真环境、设计奖励函数、训练智能体以及优化策略等步骤。通过不断迭代和优化,OpenAI的RL技术路线在智能游戏、机器人等领域取得了显著进展,为人工智能的发展开辟了新的道路。

目录导读:

随着人工智能技术的飞速发展,强化学习(RL)已成为实现智能体自我学习和决策的重要手段,OpenAI作为人工智能领域的领军者,其在自我博弈强化学习领域的研究尤为引人瞩目,本文将深入探讨OpenAI o1自我博弈RL技术路线的推演。

OpenAI与自我博弈强化学习

OpenAI是一个致力于推动人工智能发展的非营利组织,其研究成果在人工智能领域产生了深远影响,自我博弈强化学习是OpenAI重点研究的技术之一,它通过智能体在与环境的交互中学习,不断优化自身的决策策略,以实现更高级别的智能化。

三、OpenAI o1自我博弈RL技术路线概述

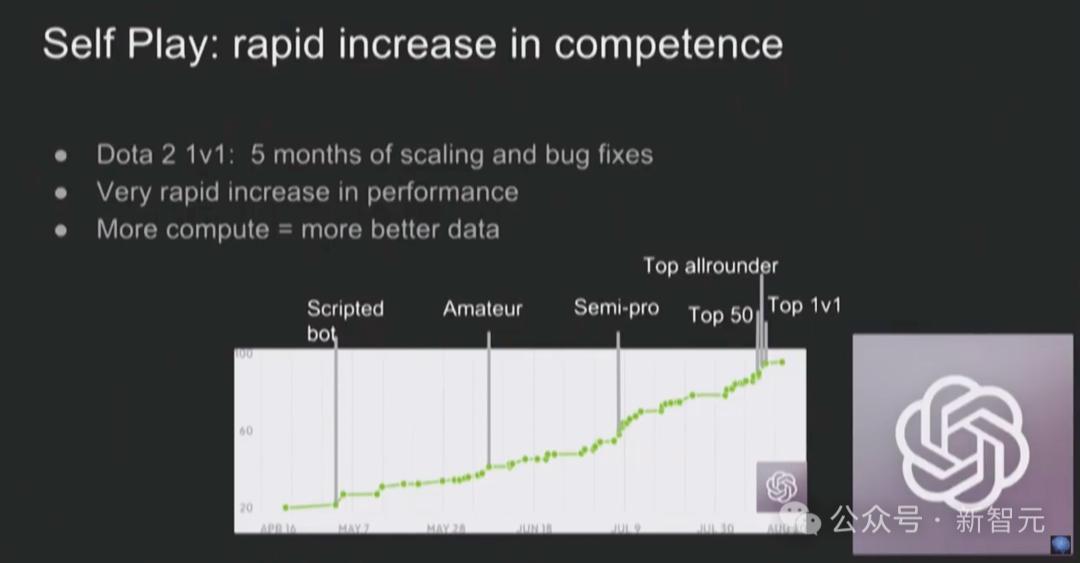

OpenAI o1自我博弈RL技术路线的核心在于通过自我博弈,让智能体在模拟环境中进行大量实践,从而学习并优化决策策略,这一技术路线的实施涉及多个关键环节,包括模型构建、训练过程、策略优化等。

模型构建

在OpenAI o1自我博弈RL技术路线中,模型构建是首要环节,研究人员需要构建一个能够模拟真实世界环境的模型,以便智能体进行实践和学习,这一模型需要具备一定的复杂性和真实性,以提供丰富的实践场景和挑战。

训练过程

在模型构建完成后,训练过程是关键,智能体通过与环境进行大量交互,收集数据并学习优化决策策略,这一过程需要借助强大的计算资源和优化的算法,以实现高效训练。

策略优化

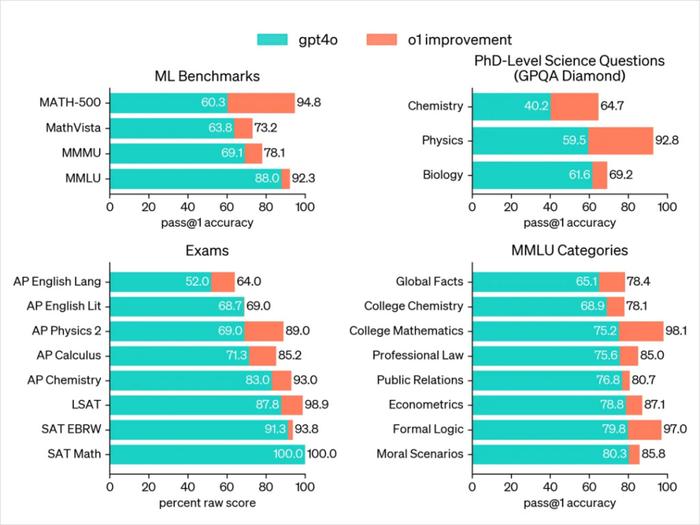

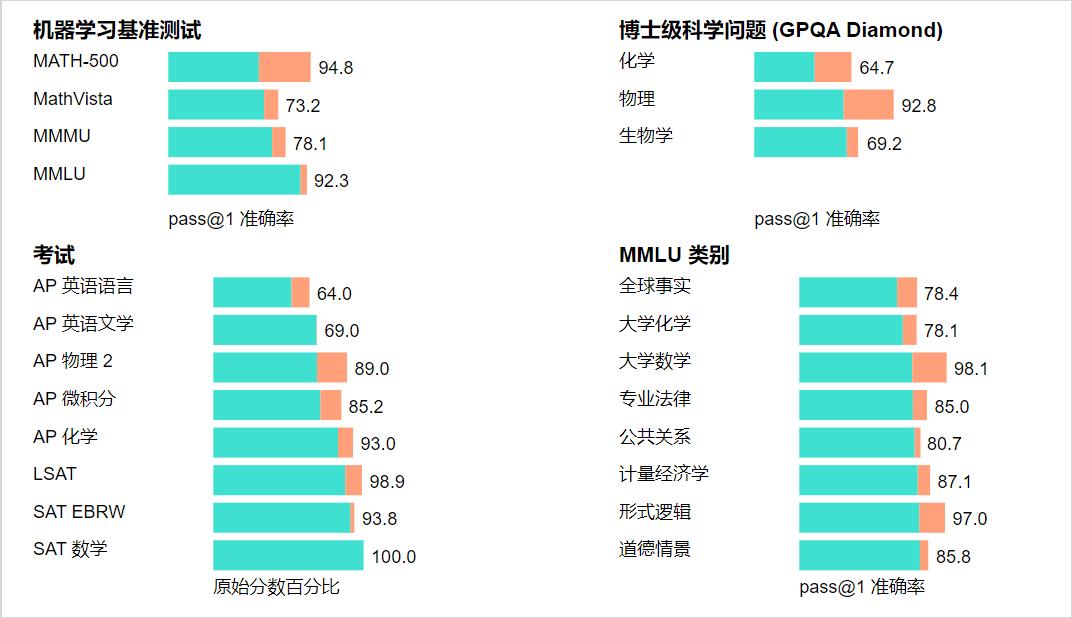

在训练过程中,智能体会根据收集到的数据不断优化决策策略,策略优化的方法包括价值函数优化、神经网络优化等,通过这些优化方法,智能体的决策能力将不断提升。

技术挑战与解决方案

在实施OpenAI o1自我博弈RL技术路线过程中,研究人员面临诸多挑战,如计算资源需求大、模型复杂度高等,为应对这些挑战,研究人员需要不断优化算法、提升计算效率、降低模型复杂度,还需要加强与其他研究机构的合作,共同推动技术的发展。

应用前景

OpenAI o1自我博弈RL技术路线在多个领域具有广泛的应用前景,如游戏智能、机器人技术、自动驾驶等,随着技术的不断发展,未来智能体将在更多领域得到应用,为人类生活带来更多便利。

未来发展趋势

OpenAI o1自我博弈RL技术路线将继续向更深层次发展,研究人员将不断优化算法和模型,提高智能体的决策能力和适应能力,随着计算技术的不断进步,训练过程将更加高效,智能体的学习能力将得到进一步提升。

本文深入探讨了OpenAI o1自我博弈强化学习(RL)技术路线的推演,从模型构建、训练过程、策略优化等方面进行了详细介绍,并分析了技术挑战及解决方案、应用前景以及未来发展趋势,随着技术的不断发展,OpenAI o1自我博弈RL技术将在更多领域得到应用,为人类生活带来更多便利和智能。

转载请注明来自徐州满江红科技有限公司,本文标题:《OpenAI o1自我博弈强化学习(RL)技术路线推演》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号